Présentation et objectifs du volume

Le présent volume porte un intérêt particulier au caractère innovant des techniques mises en œuvre et à la variété de méthodes déployées lors de la résolution des problèmes retrouvés dans la lecture des textes sur différents supports épigraphiques. Il s’agira d’observer, pour chaque cas, les critères appliqués ainsi que les solutions choisies pour répondre aux différents problèmes issus de la diversité d’inscriptions. En effet, la pertinence des outils de modélisation n’est plus à démontrer, mais le nombre d’outils et d’analyses ayant pour objectif de livrer la moindre information conservée à la surface de l’inscription est devenu extrêmement conséquent. Il devient alors important, d’une part, d’aborder leur pertinence comparée, et, d’autre part, de comparer cette pertinence aux analyses traditionnelles de l’épigraphie. Cet ouvrage constitue ainsi une première étape indispensable pour atteindre un deuxième but, celui du consensus entre les épigraphistes et modélisateurs sur les protocoles de création de modèles 3D adaptés aux caractéristiques et aux problèmes présentés par chaque inscription.

L’application de la modélisation 3D

à l’épigraphie

Avant de passer au bilan de ce qui a été réalisé en matière d’application de la modélisation 3D pour l’épigraphie, il convient de revenir rapidement sur le stade immédiatement antérieur, notamment sur la numérisation des éléments réels dans d’autres disciplines historiques. C’est par l’intermédiaire de l’archéologie, soucieuse de la virtualisation de ses corpus à des fins d’études et de conservation, que l’épigraphie a bénéficié de la méthode numérique. En effet, cette dernière s’est ouverte aux sciences archéologiques relativement tôt et elle a été considérée comme une thématique à part entière dès la fin du XXe siècle et le début du XXIe. Localement, les colloques Virtual Retrospect, organisés depuis 2003 par l’Unité Archéovision1, implantée sur le campus de Bordeaux, en sont la meilleure preuve.

Plus largement, l’intégration systématique des outils liés aux humanités numériques dans la réflexion et l’heuristique des sciences archéologiques a permis de redéfinir depuis de nombreuses années leur paysage méthodologique. L’impact profond des nouvelles technologies dans cet espace disciplinaire s’enracine dans la mise en place de méthodes et d’outils offrant une meilleure interaction entre acteurs et données. Son ancrage résulte également de la concordance entre les Sciences Humaines et notre société assujettie aux technologies numériques, concordance que les humanités numériques ne cessent d’ailleurs d’interroger sous des angles inédits, en construisant, notamment, les outils permettant à la société de s’emparer des résultats de recherche de manière toujours plus efficace.

Au même titre que de nombreux autres outils informatiques, la numérisation 3D fait incontestablement partie des humanités numériques. Son but consiste à construire, à analyser et à visualiser des résultats de corpus numériques. Elle constitue, comme chaque spécialité, un système de techniques tout à fait autonome demandant des connaissances spécifiques pour relever les défis auxquels elle fait face. La modélisation 3D s’est développée au sein des laboratoires de recherche d’archéologie des périodes préhistoriques et historiques par nécessité d’enregistrer le plus finement possible des données qui ne prennent sens que dans des relations spatialisées, qu’elles soient extrinsèques (les faits liés aux structures d’un site archéologique) ou intrinsèques (les faits présents sur un artefact ou un écofact, par exemple).

C’est par ce dernier usage que la modélisation 3D – et surtout l’analyse des modèles virtuels qui en découlent – a été introduite dans le domaine de l’épigraphie. Ainsi, si ces méthodes existent depuis plus d’une vingtaine d’années pour l’archéologie, elles ne remontent pas avant les années 2010 pour notre discipline. Et encore, si nous entendons un usage spécifique des modèles virtuels, dont l’analyse permet de quantifier des phénomènes (temporels, morphologiques, etc.) et non pas seulement une application de “vitrine” visuelle et technologique, les expériences fondatrices ont été longtemps marginales, et l’applicabilité réelle n’a cristallisé dans notre communauté qu’il y a quelques années.

Au début des années 2010, les universités et centres de recherche qui développaient ces techniques étaient encore rares et se remettaient aux compétences détenues par quelques spécialistes2. En revanche, de nos jours, les programmes de recherche centrés sur l’épigraphie, dans, par exemple, un centre comme l’institut Ausonius, proposent systématiquement un volet modélisation 3D3. Si ce phénomène est évidemment lié à l’attrait développé assez tôt par le laboratoire mentionné pour la digital epigraphy (notamment grâce à la plateforme PETRAE4) et à des pionniers dans l’usage de la 3D comme J.-P. Bost5, le même constat s’applique à de nombreux laboratoires autant en France qu’à l’étranger.

Aujourd’hui, ces méthodes ont été pleinement adoptées par la communauté, mais il faut se demander pour quels motifs cette application, bien implantée dans l’archéologie, a pris plus d’une dizaine d’années à devenir une réalité pour l’épigraphie. Nous identifions principalement trois raisons. En premier lieu, tout simplement, l’intérêt de la modélisation 3D n’a pas été compris de façon immédiate par les spécialistes de la discipline. En deuxième lieu, et probablement en lien avec la première raison, on peut évoquer un certain conservatisme dans les méthodes de lecture de la part des épigraphistes et même une méfiance. En guise d’exemple, avant la 3D, la retouche de photos d’inscriptions sur Photoshop n’était pas vue d’un bon œil, même si l’objectif était de faire mieux ressortir les lettres. Cela réveillait chez l’épigraphiste une peur atavique, qui datait des époques des humanistes et antiquaires, et qui concernait notamment les falsifications d’inscriptions6. En troisième lieu, des raisons d’ordre technique expliquent ce retard. En effet, si la généralisation des outils 3D s’est accentuée dans notre domaine au cours de la dernière décennie, c’est notamment grâce à l’essor de la puissance de calcul des ordinateurs, la miniaturisation des outils, la robustesse des solutions logicielles et l’accès à diverses solutions matérielles et logicielles pour des budgets bien inférieurs à ceux proposés auparavant.

Pour terminer ce premier et rapide tour d’horizon, il convient de nuancer nos propos par le fait que si la tendance générale montre un décalage entre disciplines, certaines équipes ont été pionnières dans la création de solutions technologiques utiles aux études épigraphiques et à celles du mobilier. On pense ici évidemment au Reflectance Transformation Imaging (RTI), dont l’invention remonte au tout début des années 2000, et qui, dès le départ, s’est concentré sur l’apport à la lecture d’artefacts anciens7. L’essor fulgurant de ce système (lié au shape-from-shading et permettant d’enregistrer en 2D les informations de réflectance à la surface des matériaux numérisés) s’explique par sa capacité à travailler extrêmement finement sur les détails discrets, grâce à diverses améliorations visuelles mettant en valeur ces détails8.

Modélisation 3D et épigraphie :

des interactions nécessaires

À ce jour, deux grands volets complémentaires se développent, distincts autant par les fonctions qu’ils remplissent que par les outils et les procédés qu’ils mettent en œuvre. Il s’agit, d’un côté, de la modélisation pour la vulgarisation des inscriptions et des supports épigraphiques dans son ensemble et, d’un autre côté, de la modélisation des surfaces des champs épigraphiques pour le déchiffrement des textes endommagées, érodés ou détériorés. Nous nous intéresserons ici à ce deuxième volet.

Des techniques variées sont utilisées pour acquérir des données scientifiquement mesurables, ainsi que pour les analyser, que ce soit dans le but de déchiffrer ce qui est difficilement perceptible à l’œil nu, ou de préserver le patrimoine virtuel des objets, et par voie de conséquence, d’avoir la possibilité de réinterroger leurs modèles ultérieurement. Dans leur variété, ces techniques se structurent néanmoins autour d’une série de processus, d’abord de création de la donnée (récolte, modélisation, conservation) et ensuite d’analyses appliquées aux données acquises. Si les processus de création dépendent entièrement de la solution technologique utilisée, ce n’est pas le cas pour les processus d’analyse. Ceux-ci sont réalisés avec un autre ensemble logiciel, non spécifique à l’acquisition, mais propre au format des données créées, dont on connaît les limites applicatives : on ne peut analyser de la même manière des nuages de points, des maillages ou des images rectifiées (voir infra).

Récolte de données

La récolte des données ne repose pas uniquement sur le choix d’une solution technologique, mais doit faire coïncider au mieux différents critères, certains liés au contexte de récolte et d’autres liés au sujet d’étude. Par exemple, pour les tablettes d’argile en Linéaire B9, il a été décidé – en raison de la fragilité et de la spécificité de ces supports – de les placer sur une plaque tournante lors de l’acquisition, afin de les manipuler le moins possible. D’autres projets, comme The Digital Rosetta Stone Project, visant à une étude et une analyse globale de cette inscription, ont dû mettre en œuvre des approches spécifiques comme la modélisation par shape-from-shading10.

La photogrammétrie

Pour autant, la méthode dominante pour l’étude virtuelle en épigraphie reste le Structure-for-Motion par corrélation photogrammétrique dense, plus habituellement appelée “photogrammétrie” (fig. 1). Pour faire simple, en utilisant une collection de photos qui mosaïquent la surface de l’objet, la photogrammétrie, en corrélant ces différents points de vue, analyse les variations pour reconstruire une représentation en 3 dimensions du sujet (avec plus ou moins de précision)11. Elle possède certains avantages, notamment sa robustesse, sa maturité, sa versatilité et son faible coût opératif.

de la partie supérieure d’un support épigraphique.

Ainsi, équipé des accessoires nécessaires et avec un protocole strict mis en place au préalable, il est possible de récolter des données optimales pour la recherche. Si l’appareil – correctement paramétré – et l’objectif sont des éléments fondamentaux, il n’en demeure pas moins qu’utiliser divers flashs, filtres, panneaux LED, échelles, équerres, sphères de réflexion, systèmes d’ombrages et trépieds constitue un véritable avantage pour améliorer la phase d’acquisition. Car, contrairement aux méthodes métrologiques (voir infra), les résultats de la photogrammétrie sont directement liés à la perfection des images sources12. Toutefois, l’usage grandissant de l’acquisition avec la caméra d’un smartphone tend à montrer depuis quelque temps qu’il est tout à fait possible d’acquérir des données sources utilisables, tant que l’approche reste qualitative (aide à la lecture) et non strictement quantitative (précision de la mesure)13, en raison de la faiblesse desdites caméras (résolution, capteur, filtres, formule optique, etc.).

À n’en pas douter, la place dominante de la photogrammétrie s’explique aussi par le fait que le système de logiciels et de méthodes est propice aux améliorations, et a transformé la pratique à de nombreuses reprises. En l’occurrence, les études morphologiques n’ont été possibles qu’à partir du moment où les solutions photogrammétriques ont permis de suffisamment densifier les modèles (voir infra) pour étudier des détails extrêmement fins.

Enfin, si la pratique actuelle semble être devenue triviale sur certains logiciels, il ne faut pas oublier que la valeur de la modélisation est proportionnelle à la rigueur des photographies acquises ; ce problème exclut, de fait, certains types d’acquisitions dont on ne peut ni connaître le paramétrage, ni enregistrer les limites, éléments obligatoires à toute expérience scientifique.

Les méthodes métrologiques

Face à cette méthode, certaines équipes préfèrent recourir à divers outils métrologiques, comme les Terrestrial LiDaR Scanners (TLS)14 ou les Coordinates Measuring Machines (CMM)15, mais surtout – pour répondre au besoin de mobilité inhérent à la modélisation épigraphique – à des scanners lasers à triangulation optique. Ces derniers appareils projettent une croix laser ou une lumière “structurée”16 sur le sujet, alors que des caméras, décalées les unes par rapport aux autres, observent la déformation du motif induite par le relief. Ainsi, par calcul trigonométrique, il est possible de numériser des surfaces et de les enregistrer à échelle réelle.

Dans ce cas aussi, les évolutions matérielles et logicielles des solutions applicables lors de la dernière décennie expliquent l’essor de leur usage. Si la numérisation en musée ou en laboratoire existe depuis longtemps, la nécessité d’être relié à une source de courant électrique constituait, jusqu’à récemment, un gros handicap limitant l’usage en extérieur, notamment sur les sites archéologiques17. De plus, les anciens modèles n’étaient pas en mesure d’enregistrer la couleur18, mais uniquement le relief, ce qui limitait l’usage général des données acquises.

Enfin, chaque appareil possédait (et possède) une gamme d’utilisation restreinte, pour un volume donné, avec une précision fixe. Certains sont donc utiles sur de petits objets, de quelques centimètres, mais restent trop consommateurs en énergie pour être utilisés sur de larges sujets. D’autres, au contraire, scannent sur une surface plus large, mais avec moins de résolution. Ainsi, suivant les objectifs, chaque scanner laser peut-être, ou non, pertinent. Il n’en reste pas moins que chacun des appareils professionnels actuels permet d’atteindre une précision infra-millimétrique, très utile pour le sujet qui nous importe dans ce siège.

On comprendra alors comment, sur ce cliché (fig. 2), S. Ganga, collaborateur dans le présent volume, avec les professeurs A. Gavini et M. Sechi, sont parvenus à déchiffrer certaines lettres peu visibles à l’œil nu sur une colonne votive, à l’aide d’un scanner laser à triangulation optique projetant une croix laser à la surface à numériser.

à triangulation optique dans Ganga et al. 2015, 1578.

L’usage de ces scanners se faisait avec un ordinateur relié pour calculer et enregistrer les surfaces numérisées. Bien que ces appareils soient toujours utilisés, les scanners de dernière génération sont indéniablement plus faciles à employer. Ils possèdent une interface intégrée, permettant de créer le modèle directement sur place, ce qui évite de les relier à un ordinateur. De même, leur autonomie est largement suffisante permettant de travailler des journées entières sur les sites. De plus, les données acquises sont polychromes. En revanche, ces appareils sont très onéreux.

Conception des modèles

Une fois l’acquisition réalisée, la conception de la donnée, pérenne et utilisable, passe par un traitement fournissant, in fine, un modèle standardisé. Par ce mot, on entend que le modèle doit contenir nécessairement les données acquises dans un format utilisable pour répondre à la problématique de recherche, mais aussi les métadonnées utiles pour comprendre ses biais, voire – pour les plus rigoureux – des paradonnées renseignant le contexte d’acquisition lui-même. Ainsi, le modèle peut être conservé et utilisé en tenant compte de ses limites, qui sont généralement, pour les modèles 3D, des erreurs d’échelles, des distorsions morphologiques, des aberrations colorimétriques ou des zones occultées.

Suivant les outils d’acquisitions utilisés, la conception des modèles est réalisée au moyen de logiciels propriétaires ou libres. Un exemple du premier cas est l’ensemble des solutions pour les scanners lasers, qui fournissent avec l’appareil la suite permettant l’exploitation des numérisations. En revanche, la photogrammétrie fait, là aussi, office d’exception : comme la donnée source est une collection de photos, plusieurs logiciels concurrents permettent de réaliser des modèles avec des algorithmes concurrents. Ils peuvent être propriétaires, libres, concerner un ou plusieurs types de modèles, ou encore demander un usage coordonné avec des logiciels tiers19. Toujours-est-il que la photogrammétrie démontre sur ce sujet une versatilité incomparable.

Analyses des modèles

Comme l’a exprimé G. Verhoeven, l’accumulation de données numériques ne sert le propos scientifique que si elle en fournit une analyse pertinente20, ainsi, d’ailleurs, que le cadre de cette analyse. À ce titre, l’usage des modèles 3D par les épigraphistes est assez exemplaire, car il y a, depuis longtemps, un objectif parfaitement délimité : aider à déchiffrer, communiquer ces déchiffrements et conserver le patrimoine virtuel des inscriptions sur une base visuelle, accessible et quantifiable. S’il est entendu qu’il est possible de réaliser sur le modèle, lorsqu’il possède un haut niveau de précision, les mêmes types d’observation que sur l’objet lui-même (application d’une lumière rasante, par exemple)21, nous nous concentrerons par la suite sur les analyses uniquement réalisables sur les modèles virtuels.

Ainsi, comme on le verra, une série d’usages s’est progressivement démocratisée au sein de la communauté, d’une part, en raison de la pertinence des analyses et, d’autre part, grâce à la mise à disposition de logiciels et solutions libres permettant de les réaliser22. On peut considérer le “nuage de points dense” (dense cloud)23 et le “maillage” (mesh)24 comme les principaux sujets des analyses pour diverses raisons, autant bibliographiques (ces éléments reviennent le plus souvent dans la plupart des publications) que techniques.

En effet, même des nuages de points extrêmement denses (et donc potentiellement précis) peuvent être analysés morphologiquement, et certains logiciels permettent donc d’en étudier les courbures ou la rugosité. Le maillage (que l’on peut qualifier de surface virtuelle) quant à lui, contient d’autres informations comme la direction de chaque face25. Il est ainsi possible d’éclairer simplement un maillage, de montrer les orientations (la carte des normales), de calculer l’ombrage ambiant local (la carte d’occlusion ambiante), d’en enregistrer les profondeurs (la carte de cavité), de calculer les pentes, ou de créer entièrement des modes de rendus optimisés pour l’étude épigraphique. Nous pensons ici à deux types de rendus : le shader “Radiance Scaling”, disponible sur des logiciels libres comme Meshlab ou 3DHOP, et certaines MatCap utilisables dans le logiciel libre Blender ou dans d’autres logiciels propriétaires.

Par la suite, nous aborderons des exemples d’autres techniques, plus complexes à mettre en place, qui, depuis quelques années, permettent de travailler au plus près du relief et de la morphologie du sujet. Nous nous attarderons en particulier sur le MRM et le dépliage de surface courbe.

Le MRM

Le Modèle de Résidu Morphologique26, ou MRM, traduit les différences spatiales entre un modèle précis et un modèle approximatif d’un même objet en informations en couleur. Il permet de faire ressortir les différences morphologiques discrètes tout en occultant les plus grandes27 (fig. 3). Il s’est révélé comme un outil formidable pour le déchiffrement d’inscriptions sur du granite, pierre à gros grain pour laquelle cette technique a permis de déchiffrer même des inscriptions méticuleusement martelées. Certains exemples permettent de discuter de ces apports analytiques. Voici une sélection des plus éloquentes.

Ainsi, Hugo Pires, de l’Universidade do Porto, a développé il y a une décennie cette technique, et un exemple de son travail, réalisé en collaboration avec Maria João Correia Santos, concerne une inscription rupestre sur granite du sanctuaire de Panoias (fig. 4). Initialement interprétée comme dédiée aux Dii Severi par Géza Alföldy, l’application de cette technique a permis de proposer une réinterprétation pointant un culte oriental, puisque l’inscription est vouée à Serapis et à Isis.

Un autre exemple concerne les sculptures tauriformes connues comme les Taureaux de Guisando (un site archéologique près d’Avila en Castille centrale). Il s’agit de quatre taureaux faisant partie d’une tradition de sculpture pré-romaine de la tribu des Vettones dans la partie centre-ouest de la péninsule Ibérique. Pour autant, ces monuments précis datent de l’époque romaine et ont servi de support à des inscriptions latines. Depuis la fin du Moyen Âge, différentes lectures de leurs textes ont ainsi été proposées. Étant donné la difficulté de l’exercice, une équipe hispano-portugaise a décidé, il y a quelques années, d’appliquer un procédé similaire à celui du sanctuaire de Panóias sur ces sculptures (fig. 5). Les résultats ont bouleversé la compréhension de ces textes, bien plus complète qu’auparavant. Il s’agit ainsi d’un groupe particulier d’inscriptions funéraires, dont les dédicacées, des familles des Lancii et des Longinii, faisaient partie de la même cognatio ou clan, les Calaetici.

Un dernier exemple, cette fois-ci sur du calcaire, intéresse le déchiffrement complet d’un règlement agraire pour la mise en culture de domaines impériaux en Afrique proconsulaire connu comme le sermo procuratorum. Il a été mené par H. González Bordas, grâce, entre autres choses, à la lecture des modèles 3D des quatre faces de l’inscription de Lella Drebblia, en Tunisie septentrionale (fig. 6)28. La pierre était divisée en un fragment supérieur, resté exposé aux intempéries, car remployé dans un cimetière musulman, et un fragment inférieur, enterré et qui ne présentait pas d’érosion. Le travail de modélisation s’est donc concentré sur le premier. Si son érosion était très importante, elle restait néanmoins homogène sur toute la surface, ce qui contribua au succès de l’opération. Le processus de lecture exigea néanmoins une certaine exhaustivité dans la mesure où l’on mit en œuvre une photogrammétrie et de nombreuses analyses29. Certains rendus du logiciel Meshlab se sont révélés particulièrement efficaces, comme le depthmap (“carte de profondeur”, un gradient de couleurs qui représente les profondeurs dans l’axe de la caméra) ou le radiance scaling (qui nuance la luminosité du modèle en fonction de ses courbures locales et de l’incidence de la lumière). En parallèle, une analyse de type MRM, doublée d’un traitement en V-RTI30, a permis de travailler sur les détails de surface depuis le logiciel RTI Viewer. Cette inscription, trouvée en début du siècle, avait été publiée de façon très incomplète par l’équipe de M. de Vos en raison de son caractère fragmentaire et des problèmes d’érosion évoqués31.

L’aplatissement de surfaces courbes

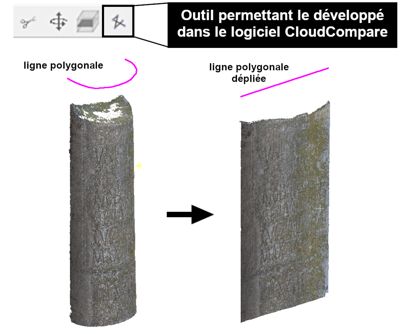

Certains corpus d’inscriptions se présentent sur des surfaces non droites, c’est par exemple le cas des bornes milliaires32. Pour autant, leurs modèles 3D peuvent être virtuellement déroulés, et elles deviennent ainsi plus facilement analysables, déchiffrables et publiables33.

Imaginé, au départ, pour trouver une solution à la publication d’images orthorectifiées de structures semi-cylindriques (des chevets d’églises médiévales), ce traitement du nuage dense permet une meilleure intégration des méthodes développées plus haut pour les épigraphes sur surfaces courbes. À plus forte raison, il peut s’appliquer à des objets dont les surfaces n’ont qu’un axe de courbure (en l’occurrence l’axe vertical), comme les bornes miliaires. Le principe a été de créer le chemin de dépliage de l’objet virtuel qui consiste en une ligne polygonale (c’est-à-dire une suite de segments de droites suivant lequel le développé est effectif). Chaque segment de ce chemin de dépliage sélectionne les points de nuage les plus proches de lui, et les replace de manière linéaire lors de son dépliage. Cette mise à plat de surfaces développables permet ainsi de déplier une surface à courbure constante sans la déformer, comme si l’on déroulait une feuille de papier.

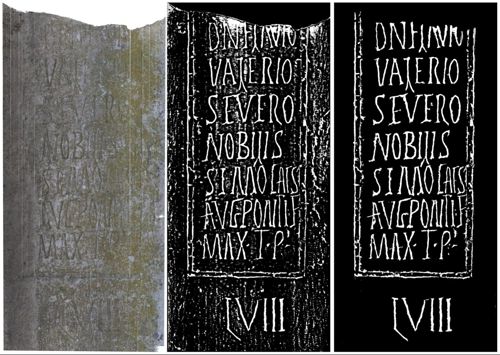

Nous pouvons observer ce déroulement en prenant une borne milliaire inédite, mais en cours de publication, provenant du centre-nord de la Tunisie34. Datant des années 306-307 p.C., elle marque la mille 58 de la voie a Carthagine Thevestem et honore l’accession de Flavius Valerius Severus à l’augustat. Il s’agit de la seule dédiée exclusivement à ce tétrarque en Proconsulaire et la deuxième en Afrique (fig. 7 et 8).

L’intérêt est triple : d’une part, les analyses sur le modèle virtuel déplié peuvent être appliquées et visualisées à l’échelle de l’ensemble de l’inscription, et non pas d’une seule partie à la fois ; d’autre part, l’inscription devient bien plus facilement lisible et communicable en deux dimensions ; enfin, contrairement à d’autres techniques de “dépliage” numérique (comme le primitive-baking qui consiste à projeter les informations à la surface d’un cylindre parfait déplié en 2 dimensions), il y a une conservation morphologique des microreliefs. Le modèle aplati n’est pas alors juste un modèle de publication, mais, à son tour, un véritable support d’analyse.

Extrêmement facile à réaliser, cette méthode présente donc un intérêt comme alternative aux présentations traditionnelles, autant celles des photos qui montrent le texte du milliaire de façon incomplète, que celle des estampages, invasifs35 et présentant un rendu souvent imparfait à cause du dépliage.

Une limite d’utilisation majeure de cette technique réside dans la déformation des reliefs, proportionnelle à l’éloignement de la ligne polygonale de développement. Ceci peut constituer un problème dans le cas de la modélisation de certains bâtiments à cause de la profondeur des portes et fenêtres. Dans ce cas, il faut diviser les plans de développement pour éviter des déformations gênantes. Mais, dans le cas de la modélisation d’inscriptions, il n’y a pas d’incidence puisque la gravure des lettres ne représente qu’une profondeur négligeable par rapport au diamètre du support lui-même. Ces déformations sont donc infimes et, par conséquent, cette limite ne concerne pas l’épigraphie.

Conclusions et ouvertures

Cette rapide introduction a montré l’aspect foisonnant et divers d’une pratique ni uniforme ni homogène, construite sur un empirisme en constante évolution. La question de la conservation pérenne des données – éminemment importante aujourd’hui – renvoie, elle aussi, pour l’instant, à une prise de conscience disparate de la communauté (en tout cas à l’échelle française). Certes, l’affaire est complexe et la somme des données générées – entre données sources, intermédiaires, finales, métadonnées et paradonnées – confine à un débat sans cesse renouvelé entre, d’un côté, la pertinence de tout conserver et de l’autre côté, la perte des éléments de l’interprétation scientifique36. Ainsi, et même si une expérience solide existe et encadre les standards de la pratique, les objectifs et les solutions applicables, nous sommes seulement au milieu du gué de l’épigraphie virtuelle.

On le disait au début de cette introduction : nous assistons aujourd’hui à une augmentation du nombre d’outils et d’analyses pouvant contribuer à conserver les informations les plus détaillées et à mieux déchiffrer les textes épigraphiques. Pourtant, cela ne veut pas dire que ces technologies sont toutes également pertinentes. Leurs capacités varient bien selon la gravure, le matériau du support ou le type d’érosion37 et leur mise en œuvre dépend d’éléments aussi variés que l’emplacement des inscriptions objet d’étude, la possibilité d’utiliser certains dispositifs ou l’utilisation de logiciels libres ou bien propriétaires pour la conception et l’analyse des modèles. En ce sens, notre ouvrage réunit des contributions questionnant ces implications pour des inscriptions problématiques, que ce soit sur une seule inscription (“The Forum Cippus. New elements from the laser scanning” de Giovanna Rocca et Giulia Sarullo) ou une série préétablie (“L’impiego di nuove tecniche digitali per la lettura delle iscrizioni: un esempio di disegno automatico dal modello 3D e un’applicazione virtuale della RTI” de Salvatore Ganga), chacune présentant des problèmes de contexte ou de lecture très particuliers ayant demandé l’usage d’analyses virtuelles très variées. De plus, notre pratique avançant, il convient d’aborder la dissémination des méthodes et des outils, là aussi – pour être le plus pertinent entre théorie et application – depuis des retours d’expériences de corpus aux caractéristiques particulières (“Sinergías digitales para la lectura de epígrafes: casuística y metodología” d’Ignacio Triguero). L’intérêt est d’autant plus grand, alors, de pouvoir s’appuyer sur les avancées de projets épigraphiques d’ampleur, comme le Digital Epigraphy and Archaeology (DEA) Project, qui, depuis 2010, questionne et supporte l’imbrication entre épigraphie et numérique, avec des solutions misant sur l’accessibilité d’acquisition et de consultation (“Reinscribing the 3rd dimension in epigraphic studies and transcending disciplinary boundaries” d’Eleni Bozia et Angelos Barmpoutis).

En matière d’épistémologie, nous nous trouvons aussi au milieu du gué : les auteurs de ces contributions se questionnent sur les problèmes théoriques posés par l’usage assumé des nouvelles technologies en général et par la modélisation 3D en particulier : E. Bozia et A. Barmpoutis reviennent sur les concepts d’authenticité, d’imitation et de copie ; S. Ganga met en exergue le lien entre les méthodes traditionnelles de lecture épigraphique et les nouvelles technologies et rappelle combien ces dernières s’inspirent des premières ; I. Triguero aborde le problème épistémologique qui pose le progressif remplacement de l’autopsie par des modélisations et intelligences artificielles, tandis que G. Rocca et G. Sarullo voient la nouvelle autopsie des inscriptions comme une action synergique combinant la lecture directe du support et celle des modèles 3D38.

Enfin, nous sommes au milieu du gué des stratégies d’analyses, car de nouvelles manières d’analyser les données se présentent encore aujourd’hui : notamment sur la forme, avec la recherche de solutions analytiques depuis des outils surprenants, comme les analyses d’inscriptions dans des logiciels de SIG (Florent Comte et Coline Ruiz Darasse).

Bibliographie

- Aounallah, S., González Bordas, H. et Maurin, L. (2022) : “Deux nouvelles inscriptions municipales de Dougga”, Chroniques d’archéologie maghrébine. Revue de l’Association Historique et Archéologique de Carthage (AHAC),2022-1, 126-129.

- Billanovich, M. P. (1967) : “Falsi epigrafici”, Italia medioevale e Umanistica, X, 25-110.

- Bost, J.-P. (à paraître) : Inscriptions Latines d’Aquitaine (ILA), Lemovices, Bordeaux.

- Bryan, P., Abbott, M. et Dodson, A. J. (2013) : “Revealing the Secrets of Stonehenge through the Application of Laser Scanning, Photogrammetry and Visualisation Techniques”, ISPRS Archives/International Archives of the Photogrammetry, Remote Sensing and Spatial Information Sciences XL (July), 125-129.

- Comte, F. (2018) : “L’utilisation des nouvelles technologies dans l’étude des inscriptions anciennes”, Travaux d’archéologie Limousine, 38, 91-102.

- Comte, F. et González Bordas, H. (à paraître) : “Une nouvelle technique pour la publication des milliaires et sa mise en œuvre pour une borne inédite de Flavius Valerius Severus”, in : Chaouali, M., Marmouri, K. et Rossignol, B. éd. : Itinera Africana, L’épigraphie routière des provinces d’Afrique en perspective, Bordeaux.

- Comte, F., González Bordas, H., Navarro Caballero, M., et Prevot, N. (2021) : “Tools Integration for Understanding and Deciphering Inscriptions PETRAE”, in : Velázquez & Espinosa Espinosa, éd. 2021, 71-82.

- De Vos, M., dir. (2000) : Rus Africum, Terra acqua olio nell’Africa settentrionale. Scavo e ricognizione nei dintorni di Dougga (Alto Tell tunisino), Trente.

- Fabián, J. F., Gimeno Pascual, H., Hernando Sobrino, R. et Pires, H. (2021) : “The ‘Toros de Guisando’ in the Digital Age”, in : Velázquez & Espinosa Espinosa, éd. 2021, 91-104.

- Ganga, S., Gavini, A. et Sechi, M. (2015) : “Nuove tecnologie applicate alla ricerca epigrafica: alcuni esempi”, in : Ruggeri, P., éd. : L’Africa romana, Atti del XX Convegno Internazionale di studi, Alghero-Porto Conte Ricerche, 26-29 settembre 2013,Rome, 1561-1584.

- González Bordas, H. et France, J. (2017) : “A new edition of the imperial regulation from the Lella Drebblia site near Dougga (AE, 2001, 2083)”, Journal of Roman Archaeology,30, 407-428.

- Malzbender, T., Gelb, D. et Wolters, H. (2001) : “Polynomial Texture Maps”, in : Pocock, L. éd. : Proceedings of ACM SIGGRAPH. ACM, New York, 519-528.

- Pires, H., Fonte, J., Gonçalves-Seco, L., Correia Santos, M. J. et Sousa, O. (2014) : “Morphological Residual Model – A tool for enhancing epigraphic readings of highly erosioned surfaces. Information Technologies for Epigraphy and Cultural Heritage”, in : Orlandi, S., Santucci, R., Casarosa, V. et Liuzzo, P. M. éd. : Information Technologies for Epigraphy and Cultural Heritage, Proceedings of the First EAGLE International Conference, Rome, 133-144.

- Pires, H., Martínez Rubio, J. et Elorza, A. (2015) : “Techniques for revealing 3D hidden archaeological features: Morphological Residual Models as Virtual-Polynomial Texture Maps”, in : ISPRS Archives, Volume Spatial XL-5/W4, 2015 3D Virtual Reconstruction and Visualization of Complex Architectures, 25-27 February 2015, Ávila, 415-421.

- Velázquez Soriano, I. et Espinosa Espinosa, D., éd. (2021) : Epigraphy in the Digital Age: Opportunities and Challenges in the Recording, Analysis and Dissemination of Inscriptions, Oxford.

- Vergnieux, R., Bernard, J.-F., Chayani, M., Abergel, V., Benistant, P., et al., dir. (2017) : Livre blanc du Consortium 3D SHS [En ligne] https://hal.science/hal-01683842v1 (consulté le 27/10/2023).

- Verhoeven, G. (2019) : “Creating a digital future for the past through unanticipated directions”, in : Del Medico, C., Dessaint, M., et Gorin, C. éd. : Méthodes d’enregistrement des données en archéologie, Paris [En ligne] https://books.openedition.org/psorbonne/38461 (consulté le 27/10/2023).

Notes

- L’ancienne UMS Archéovision est aujourd’hui intégrée à l’UMR ArchéoSciences.

- Voir dans ce volume Bozia & Barmpoutis, 82-83.

- UMR 5607.

- Programme d’Enregistrement, Traitement et Reconnaissance Automatique en Épigraphie. Voir sur ce point : Comte et al. 2021.

- Voir le corpus à paraitre, ILA Lemovices, fiche 94 (inscription de Saint-Avit-de-Tardes AE, 2018, 1141).

- Ainsi, les débats suscités par la falsification d’inscriptions et les méthodes établies pour savoir distinguer les vraies des fausses sont aussi vieux que la discipline. On peut citer en guise d’exemple l’ouvrage d’Antoni Agustí i Albanell, Dialogos de Medallas inscriciones y otras antiguedades, publié à Tarragone en 1587. Mais, au-delà des textes interpolés ou forgés pouvant apparaître sur les recueils d’épigraphes, au XVIIIe siècle, la démocratisation du goût pour les antiquités, dont les inscriptions anciennes, provoqua l’essor des contrefaçons physiques (Billanovich 1967, 42).

- Malzbender et al. 2001, 6-7. Voir dans ce volume Ganga, 59.

- Or, même si les innovations technologiques nous donneront tort d’ici peu de temps (nous l’espérons en tout cas), le RTI ne peut pas être considéré à l’heure actuelle comme une solution concurrente des différents types de modélisation 3D, mais plutôt comme une solution complémentaire (issue de l’imagerie scientifique), et ce, pour plusieurs raisons, que ce soit en termes de types de données générées, de limites et d’usages.

- https://hexagon.com/resources/resource-library/linear-b-tablets-palace-nestor (consulté le 4/05/2022).

- Bozia & Barmpoutis 2018. Voir leur contribution dans le présent volume, p. 79-94.

- En réalité, la photogrammétrie est, actuellement, une méthode de mesure spatiale basée sur le modèle de la géométrie épipolaire, et qui s’utilise généralement dans les solutions de structure-for-motion, d’une part, pour la reconstruction spatiale de la scène (positionnement des points analogues et des caméras), et d’autre part, pour la création des cartes de profondeur inhérentes à la densification du nuage de surface.

- Ainsi, ses erreurs sont estimées, et pas réellement absolues : par exemple, les erreurs d’homothétie se basent sur la méthode des moindres carrés pour estimer l’erreur d’échelle, et l’erreur de reprojection moyenne dépend de la stratégie d’optimisation des points analogues. La perfection de la collection de clichés sources est donc primordiale.

- Voir, par exemple, Aounallah et al. 2022 ou, dans ce volume, Bozia & Barmpoutis, 84.

- Bryan et al. 2013, 126.

- Les premiers ont des usages particulièrement pertinents pour des grandes surfaces. Les seconds sont extrêmement coûteux et peuvent être trop invasifs sur des pièces fragiles.

- C’est-à-dire une lumière possédant un motif unique qui est reconnu par chaque caméra de l’appareil.

- Et ce, même si les premiers scanners autonomes datent de 2012. Mais leur usage était très laborieux pour diverses raisons (ordinateurs forcément branchés, obligation d’ombrage, faible résistance aux températures estivales, etc).

- Ou seulement en niveaux de gris pour les plus perfectionnés.

- Cette coordination obligatoire est souvent une limitation des logiciels libres (à part MicMac), qui ne permettent pas de mettre à l’échelle et de positionner l’inscription ou de réaliser le maillage. Il faut donc passer par des logiciels de traitement des modèles, comme Meshlab, ou CloudCompare.

- Verhoeven 2019, §3.

- Pour les analyses similaires à celles réalisées sur le sujet réel, voir Comte 2018, 95-97.

- Au risque de nous répéter, comme Meshlab et CloudCompare.

- Ce terme renvoie à la représentation spatiale des données reconstruites dans la scène sous forme de points (x,y,z) contenant un ou plusieurs champs supplémentaires de caractéristique. On appelle ce nuage de points “dense”, car il est généré suite à l’opération de densification qui consiste à multiplier le nombre de points du nuage initial des points homologues (qui sert à placer les caméras dans l’espace 3D) grâce à la projection 3D des cartes de profondeur calculées pour chaque caméra. Voir dans ce volume Ganga, 49

- Ce terme renvoie à une modélisation géométrique qui reconstruit une véritable “surface” virtuelle en créant une série de mailles juxtaposées qui suivent la morphologie du sujet. À la différence d’un nuage de point, ou chaque élément renvoie à une position (on peut donc passer au travers), la maille, triangulaire ou quadrangulaire le plus souvent, renvoie à une surface (on ne peut pas passer au travers). Plus la maille est petite, plus la morphologie sera respectée, mais le maillage sera aussi plus lourd à manipuler. Voir dans ce volume Ganga, 53 et Triguero, 66.

- Ce vecteur normal de la face, c’est-à-dire perpendiculaire à la face (généralement appelée simplement “normale”), peu mis en avant, est, à notre avis, le plus grand intérêt des analyses de maillages, car il permet de travailler sur les orientations du relief virtuel, comme un véritable double numérique de la surface réelle. C’est avec cette normale que les améliorations visuelles et spéculaires sont réalisées.

- Il s’agit d’une technique développée par H. Pires : Pires et al. 2015.

- À la différence des cartes de profondeur, par exemple, qui permettent de mettre en avant les différences de profondeur d’une surface par rapport à une valeur absolue.

- González Bordas & France 2017.

- Grâce au travail de l’entreprise Geokali (voir fig. 1) et d’H. Pires et F. Comte, respectivement.

- Le V-RTI est une méthode insolite, reprenant l’idée du RTI mais en l’appliquant virtuellement au maillage. Si ce système ne peut servir à l’analyse fine de la réflectance de l’objet réel, il permet néanmoins un usage léger des manipulations des lumières sur le modèle 3D et sur les analyses qui y sont liées (https://ausohnum.hypotheses.org/177).

- De Vos 2000.

- C’est aussi le cas des cupae funéraires ou de certaines inscriptions rupestres.

- Nous avons notamment mis au point une technique simple, toujours grâce au logiciel CloudCompare, essentiel à l’étude numérique des corpus épigraphiques.

- Comte & González Bordas (à paraître).

- Voir dans ce volume l’article de S. Ganga, p. 48 « calco a umido con carta da filtri ».

- Nous nous bornons ainsi à rappeler que, en France, les dépôts d’archives numériques froides (c’est-à-dire sans usage pour un temps long et réclamant une conservation à faible coût et durable) au Centre Informatique National de l’Enseignement Supérieur concernent de manière obligatoire uniquement les données sources et les résultats finaux, en suivant la forme minimale attendue d’un dépôt via Altag3D (le logiciel permettant la création d’une archive validée par le CINES).

- Pour les caractéristiques des pierres utilisées comme supports épigraphiques et pour les processus d’érosion dont elles sont atteintes, voir dans ce volume, Triguero, 69-72.

- Ces contributions ont pu être présentées et débattues dans le cadre du XVIe Congrès International d’Épigraphie grecque et latine, qui s’est tenu à Bordeaux en 2022 : https://ciegl2022.sciencesconf.org/.